Miközben a vállalatvezetők egyik legfontosabb problémája, hogy eldöntsék, mennyit és miként fektessenek be a mesterséges intelligenciába (MI), nem is tudnak róla, hogy az MI modelleket, amelyek a cégéhez kerülhetnek súlyos fertőzés fenyegeti – írta a Futurism hírportál. Azokról a szoftverekről van szó, amelyek a ChatGPT 2022 végi megjelenése és használatba vétele után készültek.

A szakértők szerint ezek a mesterséges intelligencia modellek összeomolhatnak annak következtében. hogy az emberek az MI megjelenése óta a zűrzavaros kérdéseikre kapott mindenféle válaszokkal teleszemetelték az internetet. Ez a szemét bekerülhet az újabb modellek tudásanyagába. A sajátos kannibalizmussal degradálódhat az a háttértudás, amire az MI-modellek saját válaszaikat alapozzák.

A mesterséges intelligencia selejtes tartalmai mérgezik a mesterséges intelligenciát

Az MI-ipar nagy léptekkel menetel a felé az állapot felé, amikor a modelljei felkészítéséhez felhasznált emberek által előállított, autentikus információforrás kimerül. Vannak olyan szakértők, akik szerint már el is érkezett ez a helyzet. Az eredmény leegyszerűsítve az lehet, hogy selejtes tartalom kerül be az MI-modellekbe, ami növeli a valószínűségét, hogy saját válaszaik is selejtesek lesznek: megbízhatatlanná, félrevezetővé válnak.

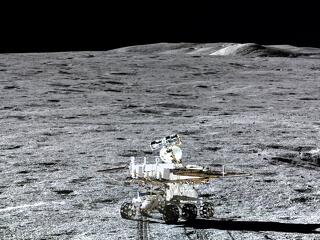

Fotó: Pixabay

A problémára válaszul a nagy fejlesztő cégek, a Google, az OpenAI, az Anthropic kitalálták az úgynevezett retrieval-argumented generation (RAG, adatkeresésre alapozott generálás) módszerét. Ez lényegében lehetővé teszi a nagy nyelvi modelleknek (LLM), hogy „szétnézve” az interneten kipótolják a tudásukat olyan ismeretekkel, amelyek a kiokosításuk után kerültek fel a világhálóra. Ez nagyon jól hangzik, leszámítva az a gondot, hogy az internet ma már tele van a lusta felhasználók olyan tartalmaival, amelyek a mesterséges intelligencia felhasználásával készültek. Ezek gyakran mulatságosan rossz vagy legalábbis pontatlan információk, amelyeket a GAC segítségével vidáman lenyelnekk az MI-modellek.

Új munkakör születhet, amit MI-ellenőrnek nevezhetünk

A Bloomberg tanulmánya szerint a legújabb LLM-ek, köztük az OpenAI GPT-40, az Anthropic Claude-3,5-Sonnet és a Google Gemma–7B modellje sokkal kevésbé biztonságos válaszokat adnak a felhasználók kérdéseire, mint a RAG képességável nem rendelkező társaik. Nagyobb gyakorisággal adnak káros, sértő, etikátlan válaszokat, illetve terjesztenek hamis információt és veszélyeztetik az emberek magánszféráját. A végeredmény az, hogy amikor a mesterséges intelligencia kimeríti a képzéséhez felhasznált adatokat, és az internetről próbálja kiegészíteni azt, akkor ingoványos talajra téved, ahol bármikor belephet egy sáros tócsába, ami bepiszkolja a tudását. A megbízhatatlanság aztán elérheti azt a szintet, amikor még nem túl okos cégvezetők is rájönnek, hogy korrigálniuk kell vagy figyelmen kívül kell hagyniuk azt, amit vállalatuk MI-modellje sugall nekik.